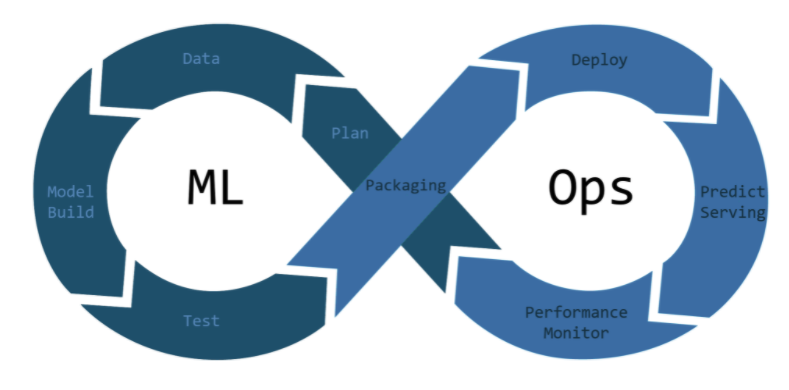

serving? ML MLmodel을 서비스화 하는 것

서빙 단계에서 막히는 이유?

- 모델 개발과 소프트 웨어 개발의 방법 괴리

- 모델 개발 과정과 소프트웨어 개발 과정의 파편화

- 모델 평가 방식 및 모니터링 구축의 어려움

서빙의 간편화를 도와주는 도구?

- seldon core

- TF Serving

- KF Serving

- Torch Serving

- BENTOML

Flask , SeldomCore 사용해서 모델 서빙하기.

Flask ?

- MSA를 위한 web app framework

- web framework : web서비스 개발을 위한 프레임 워크

- djandgo 등 framework 에 비해 괸장히 가벼우며, 확장성, 유연성이 뛰어난 프레임 워크

- 단 자체 지원 기능은 적음

- 사용하기 쉽고 간단한 기능을 가볍에 구현하기에 적합하기 때문에 대부분의 ML Model의 첫 배포step으로 Flask를 자주 사용

SeldomCore?

- 쿠버네티스에 머신 러닝 모델을 배포하는 오픈 소스 플랫폼

'Infra > MLOps' 카테고리의 다른 글

| [Docker][Flask]flask web docker image,container만들어 배포하기. (0) | 2023.04.03 |

|---|---|

| [MLops][Flask] ml model serving 구현하기_(1) (0) | 2023.04.03 |

| [Mlflow] MLflow 란? (0) | 2023.04.03 |

| [MLOps][Infra]MLOps에 jenkins CI/CD 적용 가능한 구조 고르기 (0) | 2023.04.03 |

| [airflow][crontab] 시간 설정 (0) | 2023.04.03 |